Produkt · 33 min read

Ein Beobachtungslabor einrichten

Einrichtung eines Beobachtungslabors - Hintergrundinformationen, Herausforderungen und Chancen

Einrichtung eines Beobachtungslabors: Wichtige technische Hintergrundinformationen, Herausforderungen und Chancen

1. Der Wandel der Beobachtungsforschung

Die Beobachtungsforschung ist ein zentrales Instrument wissenschaftlicher Arbeit in Disziplinen wie der Psychologie, der Human-Computer-Interaktion, der Medizin und der Ethologie. In den letzten Jahren hat sie einen Wandel durchlaufen. Der Trend geht weg von manueller Kodierung und subjektiver Auswertung hin zu technologisch gestützten Methoden. Getrieben vom Bedürfnis nach höherer Präzision und Objektivität sowie der Analyse komplexer Verhaltensmuster in realitätsnahen Umgebungen setzen moderne Forschungslabore zunehmend auf fortschrittliche Sensortechnik, spezialisierte Software und leistungsfähige IT-Infrastrukturen. Diese Technologien sind heute keine Ergänzung mehr, sondern eine Voraussetzung, um die Grenzen des Beobachtbaren systematisch zu erweitern.

Dieser Artikel gibt einen Überblick über die technischen Grundlagen, die für den Aufbau und Betrieb eines modernen Beobachtungslabors notwendig sind. Im Fokus stehen die wesentlichen Aspekte der multimodalen Datenerfassung, die eingesetzten Sensoren und Modalitäten, spezialisierte Softwarelösungen sowie Kommunikationsprotokolle für einen reibungslosen Datenfluss. Zudem werden fortschrittliche Technologien vorgestellt, die tiefere Einblicke in komplexe Verhaltensmuster ermöglichen. Der Artikel beleuchtet außerdem konkrete Anwendungsfelder, typische Herausforderungen, Einschränkungen sowie die Art der gewonnenen Daten und gängige Analyseverfahren. Ziel ist es, einen praxisnahen Leitfaden zur Nutzung der Potenziale der Beobachtungsforschung bereitzustellen.

2. Kernthemen der modernen Beobachtungsforschung

Der Aufbau eines State-of-the-Art-Beobachtungslabors beruht auf mehreren eng verzahnten Kernthemen, die Leistung und Effizienz maßgeblich bestimmen.

Verhaltensforschungslabore: Über das Traditionelle hinaus

Moderne Verhaltensforschungslabore entwickeln sich über einfache Videoaufzeichnungsanlagen hinaus. Sie werden zu integrierten Umgebungen, in denen sich das Verhalten von Menschen und Tieren beobachten, quantifizieren und detailliert analysieren lässt. Dabei werden nicht nur offensichtliche Handlungen, sondern auch subtile physiologische Reaktionen und kognitive Zustände erfasst. Der Schwerpunkt liegt auf der Schaffung kontrollierter und dennoch ökologisch valider Umgebungen, die eine systematische Untersuchung des Verhaltens als Reaktion auf bestimmte Reize oder Aufgaben ermöglichen. Bei der Gestaltung dieser Labore müssen Faktoren wie Schallisolierung, Beleuchtung, Komfort für die Teilnehmenden und die diskrete Platzierung von Sensoren berücksichtigt werden, um Störungen des natürlichen Verhaltens zu minimieren.

Multimodale Forschung: Eine ganzheitliche Perspektive

Im Fokus der heutigen Beobachtungsforschung steht das Konzept der multimodalen Forschung. Dieser Ansatz umfasst die gleichzeitige Erfassung von Daten aus mehreren unterschiedlichen Quellen oder Modalitäten. So wird ein umfassenderes und ganzheitlicheres Verständnis eines Phänomens ermöglicht. Bei der Untersuchung der Benutzererfahrung können beispielsweise Eye-Tracking-Daten (Wo ein Benutzer hinschaut), physiologische Reaktionen (Stresslevel über GSR) und verbale Protokolle (Was sie sagen) kombiniert werden. Die Stärke der multimodalen Forschung liegt in ihrer Fähigkeit, Zusammenhänge und Wechselwirkungen zwischen verschiedenen Aspekten des Verhaltens und der Kognition aufzudecken, die bei Studien mit nur einer Modalität übersehen würden. Sie ermöglicht es, Ergebnisse zu triangulieren, Beobachtungen über verschiedene Datenströme hinweg zu validieren und reichhaltigere, nuanciertere Modelle komplexer Prozesse zu erstellen.

Sensorintegration: Das vernetzte Web

Eine effektive Sensorintegration ist für eine erfolgreiche multimodale Datenerfassung von entscheidender Bedeutung. Dazu gehört nicht nur die physische Montage und Verbindung verschiedener Sensoren, sondern auch die Gewährleistung ihres nahtlosen Betriebs und der Datensynchronisation. Herausforderungen ergeben sich häufig aus unterschiedlichen Hardware-Schnittstellen, Stromversorgungsanforderungen und Datenausgabeformaten. Ein gut integriertes System minimiert die Einrichtungszeit, reduziert potenzielle Fehlerquellen und stellt sicher, dass alle Datenströme zeitlich präzise aufeinander abgestimmt sind. Dies erfordert oft maßgeschneiderte Hardwarelösungen, standardisierte Verkabelung und ein zentrales Steuerungssystem, das mehrere Eingabegeräte gleichzeitig verwalten kann.

Laborautomatisierung: Optimierung des Arbeitsablaufs

Laborautomatisierung bezieht sich auf den Einsatz von Technologie zur Optimierung und Standardisierung verschiedener Aspekte des Forschungsablaufs, von der Versuchsanordnung und Datenerfassung bis hin zur ersten Verarbeitung und Speicherung. Dazu können die automatische Kalibrierung von Sensoren, die programmierte Stimulusdarstellung, die automatische Datenprotokollierung und sogar automatisierte vorläufige Datenqualitätsprüfungen gehören. Automatisierung reduziert menschliche Fehler, erhöht die Effizienz und gewährleistet Konsistenz zwischen den Versuchen und Teilnehmern. Sie befreit von mühsamen manuellen Aufgaben und ermöglicht es, sich auf höherwertige analytische und interpretative Arbeiten zu konzentrieren.

Echtzeitanalyse: Sofortige Erkenntnisse

Die Möglichkeit der Echtzeitanalyse stellt einen bedeutenden Fortschritt in der Beobachtungsforschung dar. Anstatt auf die nachträgliche Verarbeitung zu warten, können Forschende Daten während der Erfassung überwachen und analysieren. Dies ist besonders wertvoll bei adaptiven Versuchsdesigns, bei denen Stimuli oder Aufgabenparameter möglicherweise aufgrund der laufenden Antworten eines Teilnehmers angepasst werden müssen. Die Echtzeitanalyse kann sofortiges Feedback zu den Versuchsbedingungen liefern, potenzielle Probleme mit der Datenqualität identifizieren und sogar automatisierte Interventionen oder Ereignisse innerhalb des Versuchsaufbaus auslösen. Sie erfordert eine robuste Rechenleistung und effiziente Datenpipelines, die in der Lage sind, große Datenmengen mit hoher Geschwindigkeit und minimaler Latenz zu verarbeiten.

Datensynchronisation: Die Herausforderung der zeitlichen Synchronität

Der vielleicht kritischste und technisch anspruchsvollste Aspekt der multimodalen Forschung ist die Datensynchronisation. Bei der Erfassung von Daten aus mehreren Sensoren, die jeweils mit ihrer eigenen Abtastrate und möglicherweise mit ihrer eigenen internen Uhr arbeiten, ist es für eine aussagekräftige Analyse entscheidend, dass alle Datenpunkte zeitlich präzise aufeinander abgestimmt sind. Selbst geringfügige zeitliche Abweichungen (Drifts) können zu falschen Schlussfolgerungen führen, insbesondere bei der Untersuchung schneller Verhaltens- oder physiologischer Ereignisse. Die Synchronisation verschiedener Datenströme im Sub-Millisekunden-Bereich ist eine erhebliche technische Herausforderung, die spezielle Hardware, Software und Kommunikationsprotokolle erfordert.

IT-Infrastruktur: Das Rückgrat des Labors

Eine robuste und skalierbare IT-Infrastruktur ist die Grundlage für die Arbeit in jedem modernen Beobachtungslabor. Dazu gehören leistungsstarke Rechner für die Datenerfassung und -verarbeitung, Speicherlösungen mit hoher Kapazität für große Mengen an Roh- und verarbeiteten Daten sowie leistungsfähige Netzwerke für eine effiziente Datenübertragung. Bei der Planung einer IT-Infrastruktur sind auch Aspekte wie Datensicherheit, Backup-Strategien und die Zugänglichkeit für mehrere Forschende zu berücksichtigen. Die Entscheidung zwischen lokalen Servern, cloudbasierten Lösungen oder Hybridmodellen hängt vom Umfang der Forschung, dem Budget und der Sensibilität der Daten ab. Eine angemessene IT-Infrastruktur gewährleistet Datenintegrität, ausreichende Rechenleistung für komplexe Analysen und Möglichkeiten zur gemeinsamen Forschung.

3. Sensortypen und Modalitäten: Erfassung der Nuancen des Verhaltens

Die Datenfülle in einem Beobachtungslabor ergibt sich direkt aus der Vielfalt und Präzision seiner integrierten Sensoren. Jede Modalität bietet einen einzigartigen Einblick in verschiedene Aspekte des menschlichen oder tierischen Verhaltens und der Physiologie und trägt so zu einem umfassenden Verständnis komplexer Phänomene bei. Die Auswahl und der Einsatz dieser Sensoren erfordern eine sorgfältige Abwägung der Forschungsfragen, der Umgebungsbedingungen und der Möglichkeiten zur Datenintegration.

Videobeobachtung: Die Grundlage für Beobachtungsdaten

Die Videobeobachtung bildet das Fundament der meisten Beobachtungslabore. Hochauflösende Videokameras erfassen offenes Verhalten, Interaktionen und Umweltereignisse und liefern so reichhaltige qualitative und quantitative Aufzeichnungen. Moderne Videosysteme gehen über einfache Aufzeichnungen hinaus und verfügen über Funktionen wie Infrarot für schlechte Lichtverhältnisse und synchronisierte Audioaufnahmen direkt über die Videokameras. Die Qualität der Videodaten ist für die anschließende Verhaltenscodierung und -analyse von entscheidender Bedeutung, weshalb Kameras mit guter Leistung bei schlechten Lichtverhältnissen und minimaler Latenz erforderlich sind. Die Wahl des Videoformats (z. B. MP4) und der Komprimierungsalgorithmen ist ebenfalls von entscheidender Bedeutung, um ein Gleichgewicht zwischen Dateigröße und Datentreue herzustellen. Fortschrittliche Videoaufzeichnungssysteme können auch mit anderen Sensoren integriert werden, um zusätzliche Informationen oder Bilder direkt in den Videofeed einzublenden, beispielsweise aus Gründen der Identifizierung, Sicherheit oder Einhaltung der DSGVO.

Audioaufnahmen: Eine unverzichtbare Informationsquelle.

Audioaufnahmen sind für das Verständnis visuell beobachteter Verhaltensweisen unerlässlich. Sie liefern wichtige Kontextinformation, die das Verständnis der zugrunde liegenden Ursachen eines bestimmten Verhaltens ermöglichen. Darüber hinaus können sie wertvolle Einblicke in Denkprozesse wie Problemlösung, Designentwicklung und Konfliktmanagement geben. Aus diesem Grund sind klare Audioaufnahmen für die meisten Projekte der Beobachtungsforschung von entscheidender Bedeutung. Die Aufnahme von Audio in hoher Qualität erfordert ein gut konzipiertes System und ist oft in der technischen Umsetzung komplex. Entscheidungen hinsichtlich der Mischung von Audio- und Videofeeds sowie der Aufnahme von Audio als reine Audiodatei müssen sorgfältig abgewogen werden.

Eye Tracking: Das Blickverhalten von Anwendern verstehen

Die Eye-Tracking-Technologie liefert wertvolle Einblicke in visuelle Aufmerksamkeit, kognitive Verarbeitung und Entscheidungsfindung. Durch die Beobachtung der Teilnehmenden mittels Audio- und Videoaufzeichnungen erhält man Einblicke in ihre verbalen und körperlichen Handlungen. Was sie beobachten, bleibt jedoch verborgen. Die vom Teilnehmer wahrgenommenen visuellen Informationen können jedoch wertvolle Einblicke für das Verständnis der aufgezeichneten Audio- und Videoinhalte liefern. Durch die präzise Messung der Blickrichtung, der Sakkaden, der Fixationen und der Pupillenerweiterung können Forschende Rückschlüsse darauf ziehen, was eine Person betrachtet, wie lange sie dies tut und wie sich ihre kognitive Belastung oder ihr emotionaler Zustand möglicherweise verändert. Es gibt Eye-Tracker in verschiedenen Formen, üblicherweise Systeme auf dem Tisch oder unter einem Monitor, am Kopf getragene Geräte und integrierte Lösungen in Virtual-Reality-Headsets (VR). Wichtige technische Aspekte sind dabei die Genauigkeit (Grad des Sehwinkelfehlers), die Präzision (Konsistenz der Messungen), die Abtastrate (Hz) und die Robustheit gegenüber Kopfbewegungen oder wechselnden Lichtverhältnissen. Durch die Integration von Eye-Tracking-Daten mit Videoaufzeichnungen können Heatmaps, Blickverlaufsdiagramme und Analysen von Bereichen von Interesse (AOI) erstellt werden, wodurch ein quantitatives Maß für die visuelle Aufmerksamkeit und deren Verteilung entsteht.

Biophysioligische Sensoren: Untersuchung physiologischer Reaktionen

Biophysikalische Sensoren ermöglichen die Messung subtiler physiologischer Reaktionen, die oft zugrunde liegende kognitive und emotionale Zustände widerspiegeln, und gehen somit über offensichtliches Verhalten und visuelle Aufmerksamkeit hinaus. Diese Sensoren liefern objektive, kontinuierliche Datenströme, die Verhaltensbeobachtungen ergänzen und ein tieferes Verständnis innerer Prozesse ermöglichen. Die Integration dieser vielfältigen physiologischen Signale ist kennzeichnend für fortschrittliche multimodale Forschung.

-

EEG (Elektroenzephalogramm): Ein EEG misst die elektrische Aktivität im Gehirn und spiegelt neuronale Schwingungen wider, die mit verschiedenen kognitiven Zuständen (z. B. Aufmerksamkeit, Gedächtnis, Schlaf) und ereignisbezogenen Potenzialen (ERPs) als Reaktion auf bestimmte Reize verbunden sind. EEG-Systeme reichen von hochauflösenden Forschungsgeräten mit Hunderten von Kanälen bis hin zu tragbareren Systemen mit weniger Kanälen. Zu den technischen Überlegungen gehören die Abtastrate (typischerweise Hunderte bis Tausende Hz), der Impedanzpegel (für die Signalqualität) und die Rauschunterdrückungstechniken. EEG-Daten bieten eine zeitliche Auflösung im Millisekunden-Bereich und eignen sich daher ideal für die Untersuchung des genauen Zeitpunkts neuronaler Ereignisse.

-

HRV (Herzfrequenzvariabilität): Die HRV ist ein Maß für die Schwankungen der Herzfrequenz von Schlag zu Schlag und spiegelt die Aktivität des autonomen Nervensystems (ANS) wider. Eine höhere HRV wird im Allgemeinen mit einer besseren emotionalen Regulierung und kognitiven Flexibilität in Verbindung gebracht, während eine niedrigere HRV auf Stress oder Müdigkeit hindeuten kann. Die HRV wird in der Regel aus EKG-Signalen oder Photoplethysmographie-Sensoren (PPG) (z. B. aus einem Fingerclip oder einem Wearable) abgeleitet. Die Analyse umfasst Zeitbereichs-, Frequenzbereichs- und nichtlineare Methoden, um aussagekräftige physiologische Erkenntnisse zu gewinnen.

-

EKG (Elektrokardiogramm): Das EKG misst die elektrische Aktivität des Herzens und liefert präzise Herzfrequenzdaten und Erkenntnisse über die Herzfunktion. Es handelt sich um eine grundlegende physiologische Messung, die häufig in Verbindung mit anderen Sensoren verwendet wird, um Erregung, Stress und emotionale Reaktionen zu beurteilen. Hochwertige EKG-Signale sind für eine genaue HRV-Analyse von entscheidender Bedeutung.

-

GSR/EDA (Galvanische Hautreaktion/Elektrodermale Aktivität): GSR, auch bekannt als EDA, misst Veränderungen der elektrischen Leitfähigkeit der Haut, die in direktem Zusammenhang mit der Aktivität der Schweißdrüsen stehen. Da Schweißdrüsen vom sympathischen Nervensystem innerviert werden, dient GSR als sensitiver Indikator für physiologische Erregung, Stress und emotionale Reaktionen. Es handelt sich um eine nicht-invasive und weit verbreitete Messmethode in der Psychologie- und Verhaltensforschung.

-

Atmung: Die Überwachung von Atemmuster (Frequenz, Tiefe und Regelmäßigkeit) liefert Erkenntnisse über den physiologischen Zustand, Stress und sogar die kognitive Belastung. Veränderungen in der Atmung können mit emotionalen Reaktionen, Aufmerksamkeitsverschiebungen und anstrengenden kognitiven Prozessen in Verbindung gebracht werden. Die Atmung kann mit verschiedenen Methoden gemessen werden, darunter Atemgurte, Thermistoren oder sogar indirekt durch Veränderungen der Brustimpedanz. Genaue Atmungsdaten sind wichtig für das Verständnis der physiologischen Regulation und ihrer Wechselwirkung mit anderen Verhaltens- und kognitiven Messgrößen.

Für die Integration dieser vielfältigen biophysikalischen Signale sind spezielle Hardware-Schnittstellen, synchronisierte Datenerfassungssysteme sowie robuste Software für die Verarbeitung und Analyse erforderlich. Die Korrelation dieser physiologischen Marker mit beobachteten Verhaltensweisen und Selbstauskunftsdaten ermöglicht einen leistungsstarken, mehrdimensionalen Einblick in die menschliche Erfahrung.

Mangold Observation Studio

Die fortschrittliche Software-Suite für anspruchsvolle sensorgestützte Beobachtungsstudien mit umfassenden Datenerfassungs- und Analysefunktionen.

4. Software und Plattformen: Das digitale Rückgrat der Datenerfassung und -analyse

Neben den physischen Sensoren sind die in einem Beobachtungslabor eingesetzten Software und Plattformen von entscheidender Bedeutung für die Koordinierung der Datenerfassung, die Verwaltung komplexer Versuchsaufbauten und die anschließende Analyse. Diese Tools wandeln die Rohdaten der Sensoren in aussagekräftige, synchronisierte Datensätze um, sodass Forschende Erkenntnisse aus multimodalen Informationsströmen gewinnen können. Zwar gibt es viele Lösungen, doch spezialisierte Plattformen bieten oft integrierte Funktionen, die speziell auf die Verhaltensforschung zugeschnitten sind.

Note

Die wichtigsten Funktionen und Vorteile spezialisierter Forschungssoftware zur Erfassung und Analyse von Verhaltensdaten werden anhand der Mangold-Softwarelösungen weiter unten erläutert. Sie sind repräsentativ für andere Produkte, beispielsweise Noldus Observer oder iMotions. Ein Punkt-für-Punkt-Vergleich wäre jedoch wenig sinnvoll, da sich die Produkte ständig weiterentwickeln und ähnliche, aber nicht identische Funktionen bieten. Es ist entscheidend, die Details in Bezug auf Funktionalität und Benutzererfahrung jedes Produkts zu verstehen, da diese erhebliche Auswirkungen auf die Effektivität und Effizienz der Datenerfassung und -analyse haben können. Folglich haben diese Elemente einen erheblichen Einfluss auf den Gesamtwert, der sich aus der Nutzung solcher Softwaretools ergibt. Die Benutzer:innen müssen deshalb die Eignung und Effektivität der Software für ihre spezifischen Forschungsprojekte individuell mit dem Anbieter besprechen.

Mangold VideoSyncPro: Videoaufzeichnung und Szenariokontrolle

Mangold VideoSyncPro ist eine spezielle Softwarelösung für die Audio-/Videoaufzeichnung und Szenariokontrolle in Beobachtungsforschungsumgebungen. Ihre größte Stärke liegt in der Fähigkeit, Videoaufnahmen von mehreren Kameras und Audiostreams, externe Ereignisse, Markierungen und vom Bediener eingegebene Kommentare zu synchronisieren. Dies ist entscheidend für Studien, die eine hohe zeitliche Genauigkeit zwischen allen aufgezeichneten Datenströmen erfordern, wie z. B. AV-beobachtete Verhaltensweisen und andere physiologische oder umgebungsbedingte Veränderungen. Zu den wichtigsten Funktionen gehören:

- Aufzeichnung mit mehreren Kameras: Gleichzeitige Aufnahme aus mehreren Videoquellen, wodurch eine umfassende Abdeckung des Forschungsraums und unterschiedliche Perspektiven auf das Verhalten der Teilnehmer ermöglicht werden.

- Aufzeichnung mit mehreren Audioquellen: Gleichzeitige Erfassung aus mehreren Audioquellen, wodurch Audio-Feeds mit Video-Feeds gemischt werden können, was für die spätere Analyse von entscheidender Bedeutung ist.

- Fernsteuerung von AV-Geräten: Ermöglicht die Fernsteuerung von Kameras (Schwenken/Neigen/Zoomen) und die Aktivierung/Deaktivierung von Mikrofonen sowie deren Lautstärkeregelung während der Aufzeichnung.

- Synchronisation externer Geräte: Die Möglichkeit, Trigger oder Zeitstempel von anderen Sensoren (z. B. Eye-Trackern, physiologischen Sensoren) oder experimentellen Steuerungssystemen zu empfangen, um sicherzustellen, dass alle Datenströme aufeinander abgestimmt sind.

- Szenariokontrolle: Erleichterung der Automatisierung von Versuchsprotokollen, z. B. durch die Präsentation spezifischer Reize zu vordefinierten Zeitpunkten oder als Reaktion auf Aktionen der Teilnehmer, wodurch die Versuchskontrolle und Reproduzierbarkeit verbessert werden.

VideoSyncPro fungiert als zentrale Drehscheibe für die audiovisuelle Datenerfassung und liefert die grundlegenden Audio-/Videoaufzeichnungen, die dann mit Daten aus anderen Modalitäten angereichert werden können.

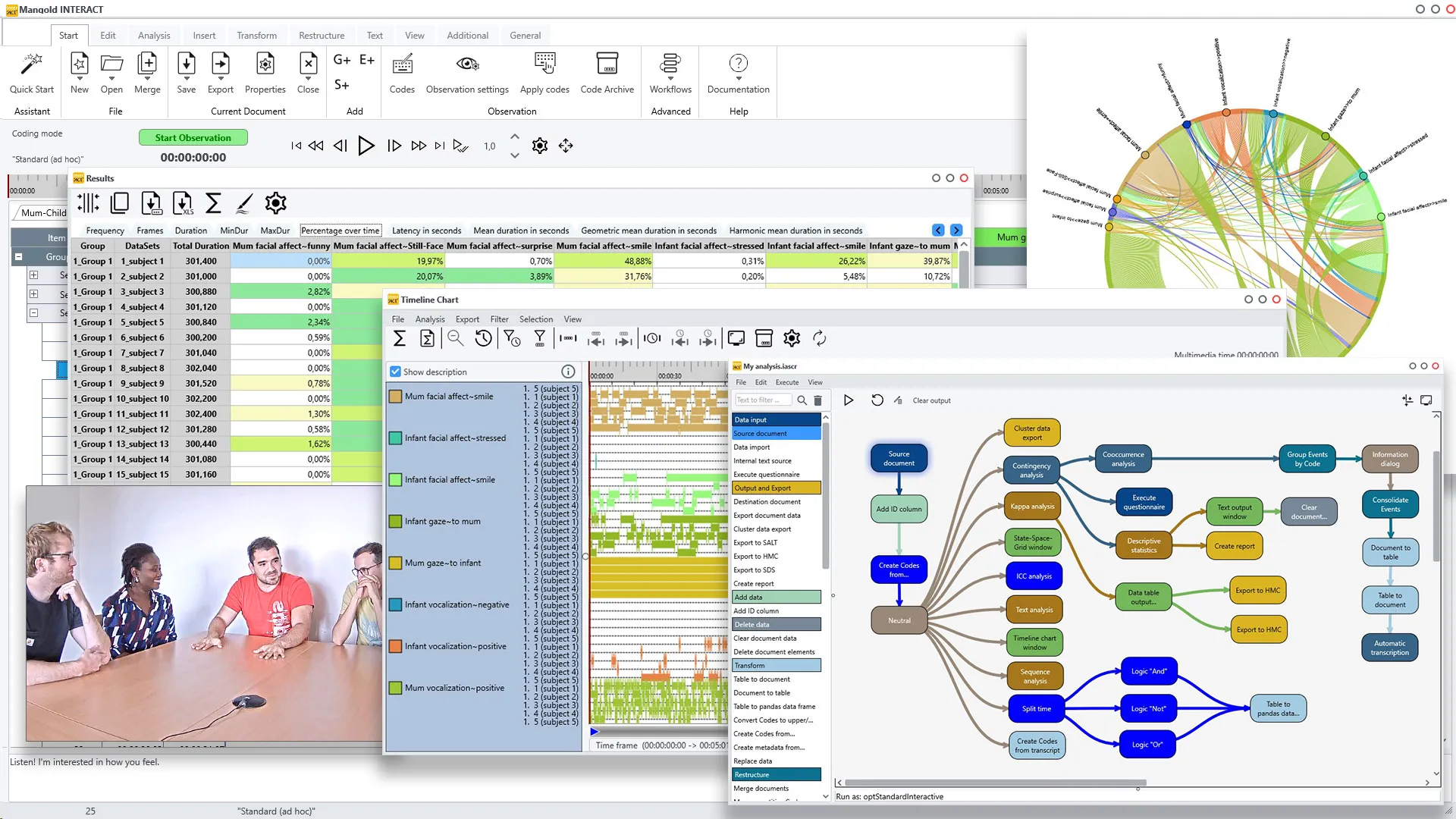

Mangold INTERACT: Fortgeschrittene Audio-/Videokodierung und Datenanalyse

Sobald Audio-/Videodaten erfasst wurden, besteht die Herausforderung darin, diese Daten sinnvoll zu interpretieren. Mangold INTERACT ist eine professionelle Softwareplattform für die deduktive und induktive Datenerfassung und qualitative Analyse von Multimediadateien. Sie wurde für die flexible und komfortable Analyse von Beobachtungen in einer Vielzahl von Experimenten entwickelt und eignet sich daher für jede Art von Beobachtungsforschung. INTERACT stellt einen Paradigmenwechsel von der einfachen Datenerfassung hin zu einer ausgefeilten Informationsgewinnung dar und ermöglicht es Forschenden, Erkenntnisse zu gewinnen, die durch reine Beobachtung allein nicht erkennbar sind, mit dem Ziel, komplexe Ergebnisse in quantitative Ergebnisse umzuwandeln

Kernfunktionen und Architektur:

INTERACT unterstützt sowohl induktive, explorative Beobachtungserfassung als auch deduktive, auf Kodierungssystemen basierende Beobachtungen. Die Software kann jede Art von zeitbezogenen Beobachtungen oder Ereignissen verarbeiten und verfügt über einen beeindruckenden Zeitbereich von 9999 v. Chr. bis 9999 n. Chr. mit einer Genauigkeit von 100 Nanosekunden für jede zeitgestempelte Information. Dieser Bereich und diese Genauigkeit setzen einen neuen Standard in der Beobachtungsforschung. Durch diese umfassende Zeitverarbeitung eignet sich die Software sowohl für die Analyse historischer Daten als auch für die zeitgenössische Forschung. Die Plattform bietet deskriptive Statistiken und leistungsstarke Analyseroutinen, beispielsweise zum Erkennen von Verhaltensmustern, ergänzt durch eine vollständige Python-Integration für erweiterte benutzerdefinierte Analyse-Workflows ohne Einschränkungen.

Video- und Audioverarbeitung:

Eine der herausragenden Funktionen von INTERACT ist die Möglichkeit, mehrere Videos gleichzeitig zu öffnen und auszuwerten, wobei die zeitliche Synchronisation perfekt beibehalten wird. Diese Funktion ist besonders wichtig für Aufnahmen mit mehreren Kameras, bei denen Forschende Szenen aus verschiedenen Blickwinkeln filmen und diese Videos gemeinsam auswerten müssen. Die Software bietet vollständige Kontrolle über die Videowiedergabe und ermöglicht es, Videos mit beliebiger Geschwindigkeit abzuspielen und zu beobachten – von sehr schnell bis extrem langsam – und sogar Frame für Frame zu navigieren, um präzise Daten zu erfassen.

Die Audioverarbeitungsfunktionen sind ebenso ausgefeilt. INTERACT kann Soundtracks für jedes Video anzeigen, was in Studien, in denen Audioinformationen von entscheidender Bedeutung sind, von unschätzbarem Wert ist. Beispielsweise in der Autismusforschung, wo ein Teilnehmer möglicherweise längere Zeit schweigt, bevor er spricht, ermöglicht die Audiovisualisierung den Forschenden, Sprachvorkommen sofort zu identifizieren und dorthin zu springen, anstatt das gesamte Video anzusehen.

Architektur des Kodierungssystems:

Die Software ermöglicht die Definition umfassender Kodierungs- oder Kategoriesysteme mit einer unbegrenzten Anzahl von Codes, die Ereignisse oder Inhalte beschreiben. INTERACT unterstützt beliebig große Kategoriesysteme mit mehreren Verzweigungen und Hierarchieebenen, was eine detaillierte Analyse komplexer Verhaltensweisen ermöglicht. Ein bemerkenswertes Beispiel ist das Facial Action Coding System (FACS), das den Ausdruck jedes einzelnen Gesichtsmuskels beschreibt. Dank der intelligenten Struktur des Kodierungssystems von INTERACT kann das gesamte FACS mit nur drei Hierarchieebenen implementiert werden.

Datenerfassung und Ereignisverwaltung:

Der Kodierungsprozess in INTERACT wird durch Tastaturkürzel oder Mausklicks während der Videowiedergabe optimiert. Wichtig ist, dass Daten auch bei angehaltenem Video aufgezeichnet werden können, was Flexibilität für detaillierte Analysen bietet. Die Software speichert alle Daten als „Ereignisse”, die jeweils eine Startzeit, eine Endzeit und eine beliebige Anzahl von Verhaltenscodes enthalten. Diese ereignisbasierte Struktur bildet die Grundlage für alle nachfolgenden Analysen.

INTERACT unterstützt umfangreiche Transkriptionen, ermöglicht unbegrenzte Textmengen pro Ereignis und erlaubt die Zuordnung zusätzlicher Datenquellen (PDFs, Textdokumente, Tabellenkalkulationen) zu Videoabschnitten per einfacher Drag-and-Drop-Funktion. Diese Multimedia-Integrationsfähigkeit ermöglicht die Erstellung reichhaltiger, kontextbezogener Anmerkungen, die über die einfache Verhaltenskodierung hinausgehen.

Datenstrukturierung und -organisation:

Ereignisse in INTERACT werden in Gruppen und Sätzen aufgezeichnet, was eine ausgefeilte Datenstrukturierung während des Protokollierungsprozesses ermöglicht. Forschende können Daten nach Themen, Testsituationen oder anderen relevanten Kategorien organisieren. Die Software bietet automatisierte Routinen zum Gruppieren von Ereignissen oder Einfügen neuer Datensätze und bietet damit nahezu unbegrenzte Flexibilität bei der Datenorganisation sowohl während als auch nach der Erfassung.

Die Metadaten-Funktionen sind besonders robust und ermöglichen es Benutzern, benutzerdefinierte Variablen und Wertelisten für Datensätze zu definieren. Dies ermöglicht eine einfache Filterung und Auswahl bestimmter Untergruppen (z. B. alle weiblichen Teilnehmer, bestimmte Altersgruppen, bestimmte Versuchsbedingungen) für gezielte Analysen.

Erweiterte Analyse und Informationsgewinnung:

Der wahre Wert von INTERACT liegt in seinen Funktionen zur Informationsgewinnung. Im Gegensatz zu herkömmlichen Statistikprogrammen, die Daten Fall für Fall analysieren, ermöglicht der zeitachsenbasierte Ansatz von INTERACT eine ausgefeilte zeitliche Analyse. Die Software kann verschiedene Arten von erweiterten Analysen durchführen:

-

Deskriptive Analyse: INTERACT beantwortet grundlegende Fragen zu Häufigkeit, Dauer und zeitlichen Beziehungen. Dazu gehören beispielsweise die Verteilung der Sprechzeit, die Häufigkeit von Fragen oder zeitliche Beziehungen zwischen verschiedenen Verhaltenskategorien.

-

Ko-Auftrittsanalyse: Die Software kann erkennen, wann und welche verschiedenen Verhaltensweisen gleichzeitig auftreten, was für menschliche Beobachter in Echtzeit kognitiv schwierig zu erkennen wäre. Beispielsweise kann sie quantifizieren, wie oft emotional motivierte Fragen während Visualisierungsperioden auftreten, und den Zeitanteil kombinierter Verhaltensweisen im Vergleich zu individuellen Verhaltensweisen berechnen.

-

Statische Intervallanalyse: INTERACT kann untersuchen, was statistisch gesehen vor oder nach bestimmten Ereignissen innerhalb definierter Zeitintervalle geschieht. Dies kann die Analyse dessen umfassen, was 3 Sekunden vor einer emotional motivierten Frage oder 5 Sekunden nach einem bestimmten Verhaltensereignis geschieht.

-

Kontingenzanalyse: Die Software analysiert kontingente Reaktionen innerhalb bestimmter Zeiträume nach Ereignissen und untersucht, wie sich diese Muster mit unterschiedlichen Variablen verändern. Dies ermöglicht es Forschenden, Verhaltenssequenzen und ihre kontextuellen Abhängigkeiten zu verstehen.

-

Sequenz- und Musteranalyse: INTERACT ermittelt Übergangswahrscheinlichkeiten zwischen Verhaltensweisen und identifiziert stabile oder sich verändernde Verhaltensmuster über verschiedene Bedingungen, Probanden oder Kontexte hinweg. Diese Fähigkeit ist entscheidend für das Verständnis von Verhaltensdynamiken und die Entwicklung von Vorhersagemodellen.

-

Qualitätssicherung und Zuverlässigkeit: INTERACT umfasst umfassende Tools zur Bewertung der Interrater-Reliabilität, wie beispielsweise Cohen’s Kappa und den Intraclass-Korrelationskoeffizienten (ICC). Diese statistischen Maße gewährleisten die Objektivität und Reproduzierbarkeit von Verhaltensbeobachtungen, was für die wissenschaftliche Validität unerlässlich ist.

-

Integration und Erweiterbarkeit: Die Software bietet umfangreiche Integrationsmöglichkeiten und ermöglicht den Import und die Anzeige von Daten aus verschiedenen Sensoren (Eye-Tracking, physiologische Daten) zusammen mit Videostreams. Diese multimodale Integration ermöglicht es Forschenden, Verhaltensereignisse mit physiologischen Veränderungen oder Blickmustern zu korrelieren und so einen umfassenden Überblick über die Reaktionen der Teilnehmer zu erhalten.

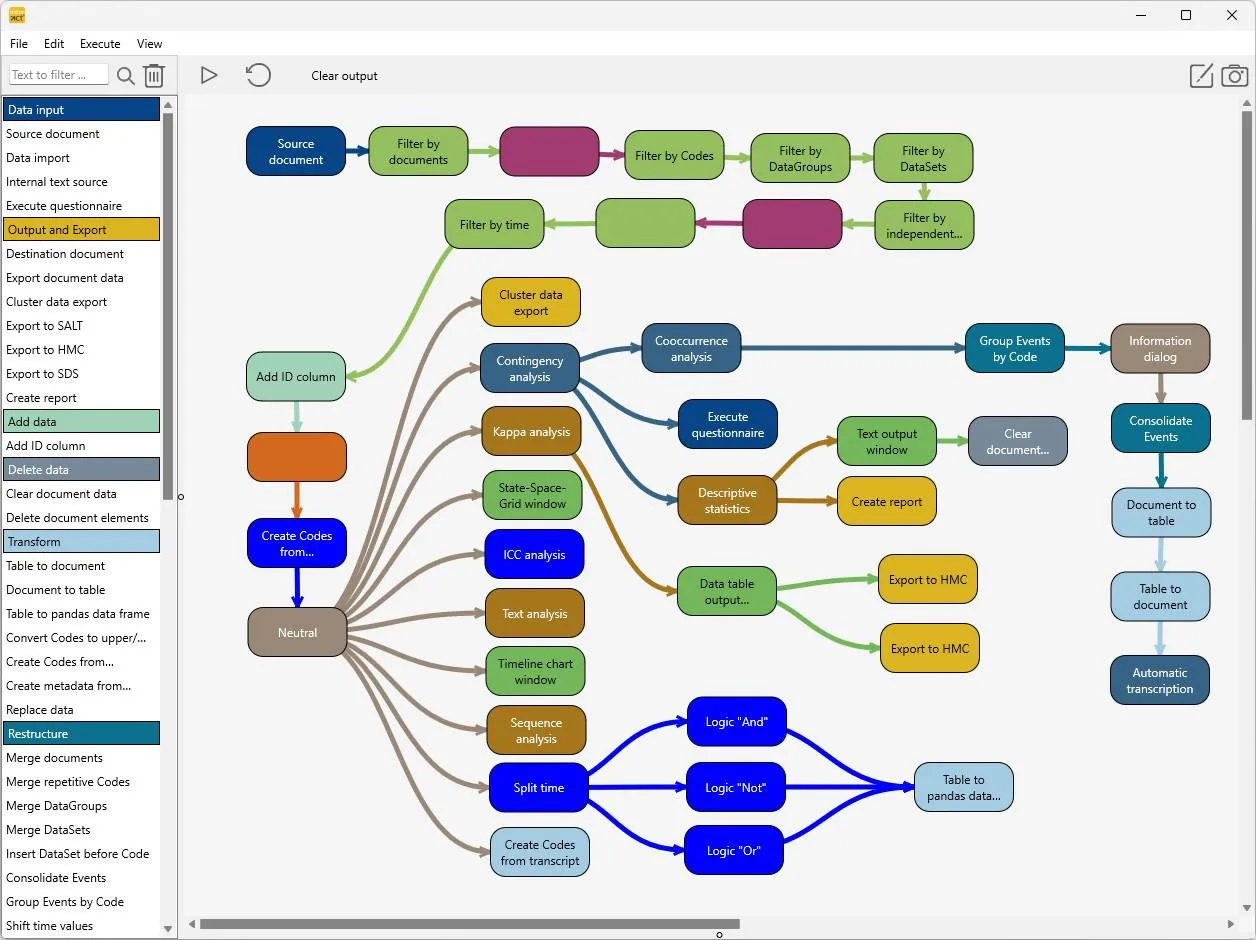

Für fortgeschrittene Benutzer bietet INTERACT einen Workflow-Editor mit vollständiger Python-Integration, der es ermöglicht, die Software um benutzerdefinierte Funktionen zum Importieren, Exportieren und Auswerten von Daten zu erweitern. Diese benutzerdefinierten Funktionen können direkt über die INTERACT-Menüleiste aufgerufen werden, sodass fortgeschrittene Analysen für ganze Forschungsteams zugänglich sind.

Vorteile gegenüber alternativen Lösungen: INTERACT behebt mehrere kritische Einschränkungen alternativer Ansätze, darunter auch Freeware-Lösungen für die Videokodierung. Die häufigsten und schwerwiegendsten Probleme treten auf, wenn Daten in ihrer Struktur und Kodierung neu organisiert werden müssen, um unvorhergesehene analytische Fragen zu analysieren oder zusätzliche Informationen hinzuzufügen. Die größten Herausforderungen im Zusammenhang mit Software, die nicht speziell für die Verhaltensforschung entwickelt wurde, sind die Flexibilität beim Importieren von Daten, die von Drittanbietersystemen erstellt wurden (z. B. Transkripte oder zeitgestempelte Ereignisdaten), und der Export von Rohdaten für die externe Bearbeitung und Weiterverarbeitung. Diese Probleme erfordern oft zeitaufwändige und fehleranfällige manuelle Datenbereinigung und -umformatierung sowie den Einsatz mehrerer Softwareprodukte, die jeweils für unterschiedliche Anwendungen entwickelt wurden.

Professionelle Lösungen wie INTERACT verhindern diese Probleme durch standardisierte Arbeitsabläufe, konsistente Datenstrukturen und vor allem durch flexible Funktionen zur Datenbearbeitung, zum Import und Export. Die INTERACT-Software deckt den gesamten Arbeitsablauf der Beobachtungsforschung ab, von der audio-/videobasierten Inhaltskodierung und Transkription bis hin zur umfassenden Analyse, und ist damit eine Komplettlösung für Verhaltensforschungslabore.

INTERACT: Die 360° Software für Ihren gesamten Forschungs-Workflow

Von der Audio/Video-Inhaltskodierung und Transkription bis zur Analyse bietet INTERACT alles in einem Tool.

Mangold Observation Studio: Umfassende multimodale Datenerfassung und -analyse

Mangold Observation Studio ist eine umfassende, integrierte Lösung für die multimodale Datenerfassung und -analyse. Es dient häufig als Alternative oder als Zusatzplattform zu VideoSyncPro und INTERACT, da es eine Vielzahl von Sensoren aufzeichnen und den gesamten Forschungsworkflow vom Versuchsaufbau bis zum Datenexport verwalten kann.

Zu den wichtigsten Vorteilen gehören:

- Zentrale Steuerung: Eine einzige Schnittstelle zur Verwaltung und Synchronisierung mehrerer Datenströme, darunter Video, Audio, Eye-Tracking und verschiedene biophysikalische Sensoren.

- Echtzeitüberwachung: Forschende können synchronisierte Datenströme während der Erfassung anzeigen und so spontan Anpassungen und Qualitätsprüfungen vornehmen.

- Integrierte Analyseumgebung: Bietet Tools für qualitative Codierung und quantitative Analyse innerhalb derselben Plattform, wodurch der Bedarf an Datenübertragungen zwischen verschiedenen Softwarepaketen reduziert wird.

- Skalierbarkeit: Entwickelt für die Verarbeitung großer Mengen multimodaler Daten, wodurch es sich für komplexe Studien mit zahlreichen Teilnehmern und langen Aufzeichnungsdauern eignet.

Observation Studio zielt darauf ab, eine nahtlose End-to-End-Lösung für die Beobachtungsforschung bereitzustellen und dabei die technischen Hürden im Zusammenhang mit der multimodalen Datenintegration und -analyse zu minimieren.

Was ist die beste Lösung für welche Situation?

Die mögliche Verwendung von Mangold Observation Studio als Alternative oder Ergänzung zu INTERACT und VideoSyncPro hängt von der jeweiligen Forschungsumgebung und den Anforderungen an die Datenerfassung und -analyse ab und muss im Detail besprochen werden.

A) Hochpräzise Audio-/Videoaufzeichnung: Mangold VideoSyncPro ist die ideale Lösung für die Aufzeichnung, während Mangold INTERACT die ideale Lösung für die Analyse ist, wenn ein Forschungslabor präzise Audio-/Videoaufzeichnungen von mehreren Audio-/Videogeräten benötigt.

B) Forschung mit Schwerpunkt auf Sensordaten: Wenn der Schwerpunkt der Forschung auf der zeitlich synchronisierten Aufzeichnung verschiedener Sensordatenströme liegt und Audio/Video lediglich eine Zusatzfunktion ist (z. B. Bildschirmaufzeichnung, Mimik der Benutzer), ist Mangold Observation Studio die optimale Wahl.

C) Sensordaten und Audio/Video gleichermaßen wichtig: Wenn die synchronisierte Aufzeichnung verschiedener Sensordatenströme ebenso wichtig ist wie die Erfassung hochwertiger Audio- und Videoströme, können alle drei Softwarelösungen nahtlos integriert werden.

Mangold Observation Studio

Die fortschrittliche Software-Suite für anspruchsvolle sensorgestützte Beobachtungsstudien mit umfassenden Datenerfassungs- und Analysefunktionen.

Überlegungen zur Integration: Über proprietäre Lösungen hinaus

Forschende arbeiten häufig mit einem vielfältigen Ökosystem aus Hardware und Software verschiedener Anbieter. Daher ist es von entscheidender Bedeutung, die Grundsätze der Überlegungen zur Integration zu verstehen. Dazu gehören:

- Offene Standards und APIs: Priorisierung von Sensoren und Software, die offene Kommunikationsprotokolle (z. B. LSL, UDP/IP) unterstützen oder gut dokumentierte Anwendungsprogrammierschnittstellen (APIs) für die benutzerdefinierte Integration bereitstellen.

- Modulares Design: Aufbau einer Laborinfrastruktur, die das flexible Hinzufügen oder Entfernen von Sensoren und Softwarekomponenten ermöglicht, ohne das gesamte System zu stören.

- Kompatibilität der Datenformate: Sicherstellen, dass Daten zwischen verschiedenen Softwarepaketen einfach importiert und exportiert werden können, was häufig Konvertierungsskripte oder Middleware erfordert.

- Benutzerdefinierte Skripterstellung und Programmierung: Nutzung von Sprachen wie Python oder MATLAB zur Entwicklung benutzerdefinierter Skripte für die Datenerfassung, -verarbeitung und -synchronisierung, wenn Standardlösungen nicht ausreichen.

Bevor Sie etwas kaufen!

Das digitale Rückgrat eines modernen Beobachtungslabors besteht aus einer effektiven Software- und Plattformauswahl gekoppelt mit einem strategischen Integrationsansatz. Dies ermöglicht die Erfassung und Analyse umfangreicher multimodaler Verhaltensdaten. Integrierte Lösungen, wie die zuvor erwähnten Mangold-Softwareprodukte, erfüllen diese Anforderungen und bieten einen erheblichen Vorteil gegenüber Produkten mit geringerer Flexibilität oder integrierter Funktionalität. Dies ist ein entscheidender Aspekt für die Effektivität und den Wert der Ergebnisse von Forschungsprojekten und muss daher vor dem Kauf von Software oder Ausrüstung sorgfältig diskutiert und verstanden werden.

5. Protokolle und Kommunikationsstandards: Gewährleistung eines nahtlosen Datenflusses und einer reibungslosen Synchronisierung

In einem multimodalen Beobachtungslabor ist es von größter Bedeutung, dass verschiedene Hardware- und Softwarekomponenten effektiv kommunizieren und ihre Datenströme synchronisieren können. Dies wird durch die Einhaltung spezifischer Protokolle und Kommunikationsstandards erreicht, die festlegen, wie Daten formatiert, übertragen und mit einem Zeitstempel versehen werden. Ohne eine robuste Kommunikation wären die umfangreichen, vielschichtigen Daten, die von verschiedenen Sensoren erfasst werden, fragmentiert und schwer sinnvoll zu integrieren.

Lab Streaming Layer (LSL): Ein universeller Datenbus für die Forschung

Lab Streaming Layer (LSL) hat sich als Standard für den Echtzeit-Datenaustausch in der Neurowissenschaft und Psychologie etabliert. LSL bietet einen einheitlichen Rahmen für das Senden und Empfangen von Zeitreihendatenströmen aus verschiedenen Quellen (z. B. EEG, Eye-Tracker, Motion Capture) an verschiedene Ziele (z. B. Aufzeichnungssoftware, Analyseskripte) über ein lokales Netzwerk. Zu seinen wichtigsten Vorteilen gehören:

- Hardware- und softwareunabhängig: LSL ist so konzipiert, dass es mit praktisch jedem Sensortyp oder jeder Software funktioniert, solange ein kompatibler LSL-Ausgang (Sender) und -Eingang (Empfänger) implementiert sind. Diese Flexibilität ist für die Integration heterogener Systeme von entscheidender Bedeutung.

- Zeitsynchronisation: LSL verfügt über robuste Mechanismen zur Zeitsynchronisation, die sicherstellen, dass Daten aus verschiedenen Strömen genau aufeinander abgestimmt werden können. Es verwendet eine hochpräzise Uhr und bietet Tools zur Schätzung und Korrektur von Netzwerklatenz und Taktabweichungen zwischen Geräten.

- Metadatenverarbeitung: LSL-Streams enthalten umfangreiche Metadaten, darunter Kanalnamen, Abtastraten, Datentypen und Geräteinformationen, die für die korrekte Interpretation und Analyse der Daten unerlässlich sind.

- Echtzeitfähigkeiten: LSL ist für die Datenübertragung mit geringer Latenz optimiert und eignet sich daher für Echtzeitanwendungen wie Biofeedback, Neurofeedback oder Closed-Loop-Versuchsdesigns.

LSL vereinfacht die komplexe Aufgabe der Integration mehrerer Datenströme, sodass sich Forschende mehr auf das Versuchsdesign und die Datenanalyse konzentrieren können, anstatt sich mit Low-Level-Kommunikationsprotokollen zu beschäftigen.

Hinweis

In Umgebungen mit vielen LSL-Streams ist es unerlässlich, dass die empfangende Software ausgereift und gut entwickelt ist. Dies ist auf die erhebliche Netzwerkbelastung zurückzuführen, die die Wahrscheinlichkeit unerwarteter Verzögerungen und Änderungen in der Reihenfolge der Datenpakete erhöht. Infolgedessen wird es schwierig, die Daten zeitlich synchronisiert anzuzeigen und zu speichern. Das Mangold Observation Studio ist sich dieser Probleme bewusst und hat eine Vielzahl von Strategien implementiert, um die höchstmögliche Präzision in Bezug auf die Hardware- und Software-Spezifikationen zu gewährleisten.

UDP/IP und TCP/IP: Grundlegende Netzwerkprotokolle

Viele Kommunikationssysteme in einem Forschungslabor basieren auf den grundlegenden Internetprotokollen: UDP/IP (User Datagram Protocol/Internet Protocol) und TCP/IP (Transmission Control Protocol/Internet Protocol). Diese Protokolle regeln, wie Datenpakete über Netzwerke gesendet werden.

- UDP/IP: UDP ist ein verbindungsloses Protokoll, d. h., es baut vor der Datenübertragung keine dauerhafte Verbindung zwischen Sender und Empfänger auf. Es ist schneller und hat einen geringeren Overhead als TCP, wodurch es sich für Anwendungen eignet, bei denen Geschwindigkeit entscheidend ist und ein gewisser Datenverlust toleriert werden kann, wie z. B. das Echtzeit-Streaming von Sensordaten (z. B. Videobilder, hochfrequente physiologische Signale). Obwohl UDP keine Zustellung oder Reihenfolge garantiert, ist es aufgrund seiner Effizienz für die Datenübertragung mit hohem Durchsatz und geringer Latenz wertvoll.

- TCP/IP: TCP ist ein verbindungsorientiertes Protokoll, das eine zuverlässige, geordnete und fehlergeprüfte Verbindung zwischen Anwendungen herstellt. Es garantiert, dass Datenpakete in der richtigen Reihenfolge und ohne Verlust übertragen werden, wobei verlorene oder beschädigte Pakete erneut übertragen werden. Diese Zuverlässigkeit macht TCP/IP ideal für Anwendungen, bei denen die Datenintegrität von größter Bedeutung ist, wie z. B. die Übertragung von Experimentbefehlen, wichtigen Sensordaten, Konfigurationsdateien oder kritischen Ereignismarkern, die nicht übersehen werden dürfen.

Viele Laborsysteme nutzen eine Kombination dieser Protokolle und setzen UDP für Hochgeschwindigkeits-Datenströme und TCP für Steuersignale und kritische Informationen ein.

IEEE 1588 PTP (Precision Time Protocol): Der Goldstandard für Zeitsynchronisation

Für Anwendungen, die höchste Genauigkeit bei der Zeitsynchronisation erfordern, insbesondere über mehrere vernetzte Geräte hinweg, ist IEEE 1588 PTP (Precision Time Protocol) der Goldstandard. PTP ist ein Protokoll, das entwickelt wurde, um Uhren in einem Computernetzwerk mit hoher Präzision zu synchronisieren, wobei oft eine Genauigkeit im Submikrosekundenbereich erreicht wird. Dies ist besonders wichtig in der Beobachtungsforschung, wo Ereignisse über verschiedene Sensoren hinweg mit extremer zeitlicher Genauigkeit abgeglichen werden müssen (z. B. die Korrelation eines bestimmten neuronalen Impulses mit einer präzisen Augenbewegung).

Im Gegensatz zu einfacheren Zeitsynchronisationsprotokollen (wie NTP) funktioniert PTP durch den Austausch von zeitgestempelten Nachrichten zwischen einer Master-Uhr und Slave-Uhren, wodurch die Slave-Uhren ihre interne Zeit präzise an die Master-Uhr anpassen können. Es berücksichtigt Netzwerkverzögerungen und Asymmetrien und bietet somit eine wesentlich höhere Genauigkeit. Die Implementierung von PTP erfordert oft spezielle Netzwerkhardware (z. B. PTP-fähige Switches) und Netzwerkkarten, aber für Forschungszwecke, die höchste zeitliche Präzision erfordern, ist es eine unverzichtbare Technologie. Die Fähigkeit, eine derart fein abgestimmte Zeitangleichung über alle Datenströme hinweg zu erreichen, ist eine bedeutende technische Errungenschaft, die die Validität komplexer multimodaler Analysen untermauert.

6. Technologische Funktionen und Konzepte: Verbesserung der Beobachtungsforschungskapazitäten

Die Integration von fortschrittlicher Hardware, hochentwickelter Software und robusten Kommunikationsprotokollen ermöglicht eine Reihe leistungsstarker technologischer Funktionen und Konzepte, die die Kapazitäten eines Beobachtungslabors erheblich verbessern. Diese Funktionen gehen über die reine Datenerfassung hinaus und ermöglichen tiefgreifendere Analysen, dynamischere Versuchsdesigns und letztlich reichhaltigere wissenschaftliche Erkenntnisse.

Ereignisauslösung: Präzision in der experimentellen Steuerung

Ereignisauslösung bezeichnet den Mechanismus, durch den bestimmte Ereignisse oder Reize innerhalb eines Experiments ausgelöst werden, oft in präziser zeitlicher Beziehung zu anderen Datenströmen. Dies kann das Senden von Signalen von einem zentralen experimentellen Kontrollsystem an externe Geräte (z. B. das Anzeigen eines Bildes auf einem Bildschirm, das Abspielen eines Audio-Cues, das Aktivieren eines haptischen Feedback-Geräts) oder das Empfangen von Signalen von Sensoren (z. B. ein Tastendruck, eine bestimmte physiologische Reaktion) umfassen, um deren Auftreten zu markieren. Die Präzision der Ereignisauslösung ist entscheidend für eine genaue Zeitsynchronisation und für die Herstellung kausaler Beziehungen zwischen Reizen, Reaktionen und internen Zuständen. Moderne Systeme verwenden häufig dedizierte Hardware-Trigger (z. B. TTL-Impulse) oder netzwerkbasierte Trigger (z. B. LSL-Marker), um eine Genauigkeit im Sub-Millisekunden-Bereich zu gewährleisten, was eine detaillierte Analyse von Reaktionszeiten und ereignisbezogenen Potenzialen ermöglicht.

Videokodierung: Quantifizierung von Verhalten anhand visueller Daten

Videokodierung, auch als Verhaltenskodierung oder Annotation bekannt, ist der systematische Prozess, bei dem kontinuierliche Videoaufzeichnungen von Verhalten in diskrete, quantifizierbare Datenpunkte umgewandelt werden. Forschende definieren bestimmte Verhaltensweisen (z. B. Blickabwendung, Lautäußerungen oder bestimmte motorische Handlungen) und markieren dann systematisch deren Beginn, Ende und Dauer auf der Timeline des Videos. Dieser Prozess kann manuell, halbautomatisch oder vollautomatisch erfolgen. Die manuelle Codierung ist zwar arbeitsintensiv, ermöglicht jedoch eine differenzierte Interpretation. Halbautomatische Tools können dabei helfen, bestimmte Merkmale (z. B. Gesichtsausdrücke oder Körperhaltungen) zu erkennen, die dann von den Codierern verfeinert werden. Das Ergebnis der Videokodierung ist ein strukturierter Datensatz, der statistisch analysiert werden kann. So können Forschende Verhaltenshäufigkeiten, -dauern und -sequenzen quantifizieren. Die Zuverlässigkeit der Videokodierung wird häufig anhand von Metriken zur Übereinstimmung zwischen den Bewertern (z. B. Cohens Kappa) bewertet, um die Objektivität und Reproduzierbarkeit der Beobachtungen sicherzustellen.

Datenfusion: Integration unterschiedlicher Informationen

Datenfusion ist der Prozess der Kombination von Daten aus mehreren unterschiedlichen Quellen. Das Ziel besteht darin, eine konsistentere, genauere und nützlichere Darstellung eines Phänomens zu erhalten, als dies mit einer einzelnen Datenquelle allein möglich wäre. In einem Beobachtungslabor umfasst dies die Integration von Daten aus Video-, Audio- und Eye-Tracking-Aufnahmen sowie von verschiedenen biophysikalischen Sensoren. Das Ziel besteht darin, einen einheitlichen Datensatz zu erstellen, in dem alle Messungen zeitlich und räumlich präzise aufeinander abgestimmt sind. Datenfusionstechniken können von der einfachen Verkettung von Zeitreihendaten bis hin zu komplexeren statistischen oder maschinellen Lernansätzen reichen, die Muster und Beziehungen zwischen verschiedenen Modalitäten identifizieren. Eine effektive Datenfusion ist für die multimodale Forschung unerlässlich, da sie es Forschenden ermöglicht, komplexe Wechselwirkungen zwischen verschiedenen Aspekten des Verhaltens und der Physiologie zu untersuchen.

Zeitsynchronisation: Der Grundstein der multimodalen Analyse

Wire bereits erwähnt, ist die Zeitsynchronisation ein entscheidendes technologisches Konzept, das allen multimodalen Beobachtungsstudien zugrunde liegt. Es bezieht sich auf den Prozess, bei dem sichergestellt wird, dass alle Datenströme, die von verschiedenen Sensoren und Aufzeichnungsgeräten stammen, präzise auf eine gemeinsame Zeitachse abgestimmt sind. Ohne eine genaue Zeitsynchronisation ist es unmöglich oder höchst unzuverlässig, Ereignisse über verschiedene Modalitäten hinweg zu korrelieren (z. B. eine bestimmte physiologische Reaktion mit einer bestimmten Verhaltensaktion). Die Techniken reichen von hardwarebasierten Lösungen (z. B. gemeinsame Taktsignale, PTP) bis hin zu softwarebasierten Methoden (z. B. interne Uhrkorrekturalgorithmen von LSL, nachträgliche Ausrichtung auf der Grundlage gemeinsamer Ereignismarker). Das Erreichen und Aufrechterhalten einer hochpräzisen Zeitsynchronisation ist eine kontinuierliche technische Herausforderung, die eine sorgfältige Planung und wohlüberlegte Umsetzung erfordert.

Echtzeit-Ereigniserkennung: Dynamische Einblicke

Bei der Echtzeit-Ereigniserkennung werden bestimmte Ereignisse oder Muster in Datenströmen identifiziert, sobald sie auftreten, anstatt auf eine nachträgliche Analyse zu warten. Diese Funktion ist besonders wertvoll für adaptive Versuchsdesigns, bei denen das Versuchsparadigma dynamisch auf das Verhalten oder den physiologischen Zustand eines Teilnehmers reagieren muss. Ein System könnte beispielsweise einen plötzlichen Anstieg der GSR (der auf Erregung hindeutet) erkennen und sofort einen neuen Reiz präsentieren. Die Echtzeit-Ereigniserkennung basiert auf effizienten Algorithmen und Rechenressourcen, die in der Lage sind, große Datenströme mit minimaler Latenz zu verarbeiten. Diese Technologie eröffnet Möglichkeiten für Closed-Loop-Experimente, Biofeedback-Anwendungen und sofortiges Feedback zu Versuchsbedingungen.

Sensorfusion: Mehr als nur einfache Integration

Aufbauend auf der Datenfusion bezeichnet Sensorfusion den Prozess der Kombination von Daten aus mehreren Sensoren, um die Genauigkeit, Vollständigkeit oder Zuverlässigkeit der Informationen zu verbessern. Während es bei der Datenfusion darum geht, Daten zusammenzuführen, umfasst die Sensorfusion oft komplexere Algorithmen, die die komplementären Stärken verschiedener Sensoren nutzen, um eine robustere Messung zu erzielen. Beispielsweise kann die Kombination von Daten aus einem Beschleunigungsmesser und einem Gyroskop eine genauere Schätzung der Kopfbewegung liefern als jeder der beiden Sensoren allein. In einem Beobachtungslabor kann die Sensorfusion die Kombination von Eye-Tracking-Daten mit der Ausrichtung eines Head-Mounted-Displays umfassen, um die Blickrichtung in einer dynamischen Umgebung präzise zu bestimmen, oder die Integration von Motion-Capture-Daten mit Video, um Verhaltensannotationen zu verfeinern.

Geschlossene Regelkreise: Responsive experimentelle Paradigmen

Geschlossene Regelkreise sind experimentelle Aufbauten, bei denen die Ausgabe eines Systems (z. B. die physiologische Reaktion oder das Verhalten eines Teilnehmers) in das System zurückgeführt wird, um dessen Eingabe (z. B. die Darbietung von Reizen) zu modifizieren. Dadurch entsteht eine dynamische, interaktive Versuchsumgebung, die sich in Echtzeit an den Teilnehmer anpassen kann. Beispiele hierfür sind Neurofeedback-Systeme, bei denen dem Teilnehmer seine Gehirnaktivität präsentiert wird, um Selbstregulierung zu erlernen, oder adaptive Lernumgebungen, die den Schwierigkeitsgrad anhand der Leistung anpassen. Die Implementierung von Closed-Loop-Systemen erfordert robuste Funktionen zur Echtzeit-Datenerfassung, -verarbeitung und -auslösung sowie ausgefeilte Algorithmen zur Bestimmung des geeigneten Feedbacks oder der geeigneten Intervention.

KI-gestützte Transkription: Automatisierung der qualitativen Datenanalyse

Das Aufkommen der künstlichen Intelligenz (KI) revolutioniert die Verarbeitung qualitativer Daten in der Beobachtungsforschung. KI-gestützte Transkription nutzt Sprach-zu-Text-Algorithmen, um Audioaufzeichnungen von verbalen Protokollen, Interviews oder spontanen Äußerungen automatisch in geschriebenen Text umzuwandeln. Dies reduziert den arbeitsintensiven Prozess der manuellen Transkription erheblich und macht die Analyse qualitativer Daten in großem Umfang praktikabler. Obwohl die KI-Transkription noch nicht perfekt ist und oft eine Überprüfung und Korrektur durch Menschen erfordert, liefert sie einen wertvollen ersten Durchgang, der es Forschenden ermöglicht, verbale Daten schnell zu suchen, zu analysieren und zu kodieren. Weitere KI-Anwendungen erstrecken sich auf die automatisierte Verhaltenserkennung aus Videos, die Stimmungsanalyse aus Sprache und sogar die automatisierte Ereigniserkennung.

GPU-gestützte Verarbeitung: Beschleunigung der Datenanalyse

Die schiere Menge und Komplexität multimodaler Daten erfordert oft erhebliche Rechenleistung. GPU-gestützte Verarbeitung (GPU, Graphics Processing Unit) nutzt die parallelen Verarbeitungsfähigkeiten von GPUs, um rechenintensive Aufgaben wie Videoverarbeitung, Algorithmen für maschinelles Lernen und komplexe statistische Modellierung zu beschleunigen. GPUs eignen sich besonders gut für Aufgaben, die in viele kleinere, unabhängige Berechnungen unterteilt werden können, wie Bilderkennung, Training neuronaler Netze und Signalverarbeitung. Die Integration von GPU-gestützten Workstations oder Servern in die IT-Infrastruktur des Labors kann die Datenverarbeitungszeiten drastisch reduzieren und ermöglicht so eine schnellere Bearbeitung von Analysen und Iterationen zu Forschungsfragen.

Latenzmanagement: Minimierung von Verzögerungen in Echtzeitsystemen

Latenzmanagement ist ein entscheidender Faktor in jedem Echtzeit-Beobachtungssystem. Latenz bezeichnet die Verzögerung zwischen dem Eintreten eines Ereignisses (z. B. der Antwort eines Teilnehmers, einer Sensorauslesung) und der Registrierung, Verarbeitung oder Reaktion des Systems auf dieses Ereignis. In Closed-Loop-Experimenten oder Echtzeitanalysen kann eine hohe Latenz die Validität des Experiments oder die Wirksamkeit der Intervention beeinträchtigen. Ein effektives Latenzmanagement umfasst die Optimierung von Hardware (z. B. Hochgeschwindigkeits-Datenbusse, dedizierte Verarbeitungseinheiten), Software (z. B. effiziente Algorithmen, optimierter Code) und Netzwerkkonfigurationen (z. B. Protokolle mit geringer Latenz, direkte Verbindungen), um Verzögerungen zu minimieren. Das Verständnis und die Quantifizierung der Latenz über die gesamte Datenpipeline hinweg ist für die Entwicklung robuster Echtzeitsysteme von entscheidender Bedeutung.

Semantische Ereignisschichten: Daten mit Bedeutung versehen

Semantische Ereignisschichten beinhalten das Hinzufügen von aussagekräftigen, für Menschen interpretierbaren Beschriftungen und Anmerkungen zu Rohdatenströmen. Während Sensoren physikalische Rohsignale erfassen, wandeln semantische Ereignisschichten diese Signale in höherwertige, konzeptionell reichhaltige Informationen um. Beispielsweise können Rohdaten aus der Bewegungserfassung in semantische Ereignisse wie „Gehen“, „Sitzen“ oder „Greifen“ übersetzt werden. In ähnlicher Weise können physiologische Daten mit semantischen Bezeichnungen wie „Stressreaktion“ oder „kognitive Anstrengung“ versehen werden. Diese Ebenen werden häufig durch eine Kombination aus manueller Codierung, regelbasierten Algorithmen und Modellen des maschinellen Lernens erstellt. Semantische Ereignisebenen erleichtern die Interpretation, ermöglichen komplexere Abfragen und Analysen und schließen die Lücke zwischen Rohdaten und theoretischen Konstrukten, wodurch die Daten für ein breiteres Spektrum von Forschungsfragen zugänglicher und nützlicher werden.

7. Fazit: Die Zukunft der Beobachtungsforschung

Die Landschaft der Beobachtungsforschung entwickelt sich rasant weiter, angetrieben durch Fortschritte in der Sensortechnologie, Rechenleistung und Datenwissenschaftsmethoden. Die Einrichtung eines modernen Beobachtungslabors ist ein komplexes Unterfangen, das eine sorgfältige Abwägung der technischen Infrastruktur, Software-Integration, Kommunikationsprotokolle und Datenmanagementstrategien erfordert. Die Herausforderungen werden jedoch bei weitem durch die Möglichkeiten aufgewogen, beispiellose Einblicke in das Verhalten, die Kognition und die Physiologie von Menschen und Tieren zu gewinnen.

Zukünftige Entwicklungen: Hin zu stärker integrierten und intelligenteren Labors

Die Zukunft der Beobachtungslabors weist in Richtung einer noch stärkeren Integration und Intelligenz. Wir können Folgendes erwarten:

- Miniaturisierung und Wearables: Kleinere, weniger störende Sensoren und tragbare Geräte werden eine natürlichere Datenerfassung in einer größeren Bandbreite von Umgebungen ermöglichen und die Forschung aus dem Labor hinaus in den Alltag verlagern.

- Fortschrittliche KI und maschinelles Lernen: KI wird eine immer zentralere Rolle spielen, nicht nur bei der Datenanalyse, sondern auch bei der Echtzeit-Ereigniserkennung, der automatisierten Versuchskontrolle und sogar bei der Generierung von Hypothesen aus komplexen Datensätzen.

- Integration von virtueller und erweiterter Realität: VR/AR wird hochgradig kontrollierte und dennoch immersive Umgebungen für die Verhaltensforschung bieten, die eine präzise Manipulation von Reizen und Kontexten ermöglichen und gleichzeitig reichhaltige multimodale Daten erfassen.

- Cloud-basierte Infrastruktur: Eine stärkere Nutzung von Cloud Computing für die Datenspeicherung, -verarbeitung und gemeinsame Analyse wird die Skalierbarkeit, Zugänglichkeit und den Datenaustausch zwischen Forschungseinrichtungen verbessern.

- Ethische KI und Datenschutz: Da die Datenerfassung immer weiter verbreitet und ausgefeilter wird, wird den ethischen Überlegungen, dem Datenschutz und dem verantwortungsvollen Einsatz von KI in der Verhaltensforschung zunehmend Aufmerksamkeit geschenkt werden.

Wichtige Empfehlungen für den Aufbau eines modernen Labors

Für Forschende, die sich auf den Weg machen, ein Beobachtungslabor aufzubauen oder zu modernisieren, ergeben sich mehrere wichtige Empfehlungen:

- Priorisieren Sie Interoperabilität: Investieren Sie in Hardware und Software, die offene Standards unterstützen und robuste APIs bieten, um Kompatibilitätsprobleme zu minimieren und Zukunftssicherheit zu gewährleisten.

- Konzentrieren Sie sich auf die Zeitsynchronisation: Da eine präzise Datensynchronisation die Grundlage für multimodale Analysen ist, ist es unabdingbar in Technologien zu investieren, die diese Synchronisation bestmöglich sicherstellen können.

- Planen Sie die Datenverwaltung: Entwickeln Sie von Anfang an umfassende Strategien für die Speicherung, Sicherung und Organisation von Daten unter Berücksichtigung des Umfangs und der Vielfalt der generierten Daten.

- Nutzen Sie Automatisierung: Setzen Sie Automatisierungstools für die Experimentsteuerung, Datenerfassung und Vorverarbeitung ein, um die Effizienz zu steigern und menschliche Fehler zu reduzieren.

- Investieren Sie in spezialisierte Software: Sensorhardware, Audio-/Videogeräte und Rechenleistung sind nur Teil des Ganzen. Spezialisierte Software zur Erfassung von Audio-/Videodaten und Sensordaten ist entscheidend für die Erstellung zuverlässiger Datensätze für die weitere Analyse.

- Wählen Sie Lösungen, die zukunftssicher sind: Investieren Sie in Lösungen, die zukunftssicher und modular erweiterbar sind und vor allem einen offenen Austausch von Rohdaten ermöglichen.

- Stellen Sie sicher, dass Sie die erforderliche Unterstützung erhalten: Es ist wichtig, Tools auszuwählen, die von einer Quelle stammen, die wesentliche Unterstützung bei der Bewältigung technischer Herausforderungen bietet, sich an sich ändernde Forschungsanforderungen anpassen lässt und Anleitung zu Forschungsdesign, Datenerfassung und -analyse bietet. Open-Source- und Freeware-Tools sind eventuell nicht in der Lage, Ihnen in der benötigten Zeit Lösungen und Hilfestellung zu liefern.

- Speichern Sie Ihre Daten in einer Toolkette: Investieren Sie in eine Toolkette, die Daten wirklich nahtlos zwischen Tools übertragen kann, um fehleranfällige und zeitaufwändige manuelle Datenverarbeitung zu vermeiden.

- Wählen Sie die richtigen Tools: Wählen Sie Tools, die letztendlich Antworten auf Ihre Forschungsfragen liefern, ohne dass n+1 verschiedene manuelle Datentransformationen erforderlich sind.

Abschließende Gedanken zu den Chancen: Neue Entdeckungen erschließen

Investitionen in fortschrittliche Beobachtungsforschungsinfrastrukturen führen letztendlich zu bedeutenden Fortschritten in unserem Verständnis des Themas. Durch die Überwindung technischer Herausforderungen können Forschende differenziertere Fragen stellen, umfassendere Daten erfassen und tiefere Einblicke in die Komplexität des Verhaltens und des menschlichen Geistes gewinnen. Von der Optimierung der Benutzererfahrung über die Weiterentwicklung klinischer Interventionen bis hin zum Verständnis grundlegender kognitiver Prozesse ist ein modernes Beobachtungslabor ein leistungsstarker Motor für den wissenschaftlichen Fortschritt. Dieser Fortschritt verspricht eine Zukunft, in der unser Verständnis von Verhalten präziser, objektiver und ganzheitlicher ist als je zuvor.

Mangold Beobachtungslabore

Entdecken Sie schlüsselfertige Lösungen für wissenschaftliche Audio/Video-Beobachtungsstudien.

- Behavioral research software

- Bias reduction

- Content analysis

- Data analysis

- Data collection

- Data integration platforms

- Ethics

- Ethnographic research

- Experiment

- Falsifiability

- Grounded theory

- Mixed-methods research

- Observational coding software

- Qualitative

- Quantitative

- Replicability

- Survey

- Video analysis systems